01

人工智能大模型更近了

chatgpt3 发布,chatgpt4升级,文心一言开放测试,office套件copilot发布。 随手就可获得颠覆性的个人助理,不用再花心思调戏Siri了。

生成式的模型面前,代码,图像,视频,小说,作文,各种文案,脑力打工人集体失色了。这些场景出现在了我幻想的未来里。

人工智能大模型chatgpt确实好用,掀起了新一轮人工智能的竞赛浪潮。

但是回归到商业的本质,谁才能坚持到最后,怎么样才更有可能坚持到最后呢?

02

大模型训练的算力成本分析

人工智能三要素,算力,算法和数据。

算力是基础设施。大模型的成本主要可以拆分成训练和推理两个阶段的算力成本。训练是周期性投入,推理则是长期的投入。

根据行业调研信息,AI训练的算力增长符合摩尔定律,大约每20个月翻一番;深度学习的出现加速了性能的扩展,用于AI训练的算力大约每6个月翻一番;而目前大规模模型出现,其训练算力是原来的10到100倍。

在大模型训练时,微软专门打造的超级计算装置,使用了1万张A100 GPU卡,耗时一个月,才完成1700多亿参数的chatgpt3的训练。训练成本约500万美元/次。

模型部署服务用户,进入推理阶段:对用户的文字等信息输入,进行处理,反馈结果给用户。根据模型的参数规模以及优化情况,后台可能需要1张或多张GPU卡,服务一个或多个用户。

不同的并发用户数,这个阶段的花费弹性巨大,难以预估。据统计,ChatGPT每日推理成本在28万美元左右。

企业通常都求助于云计算服务商。现状是,国内没有一家云计算公司可以在一个机房里提供1万张A100的算力。个人和小企业的投资在AI大模型的时代就更加捉襟见肘了。

由于人类对智能的研究还未有可靠的理论依据,于是导致人工智能的不可解释性,缺乏通用性和可移植性。chatgpt这种大力出奇迹的工程,可能造成巨大的浪费,也可能造成霸权和垄断。

几年前人工智能开始盛行的时候,李开复先生在《AI ▪ 未来》的书中描述,通用的AI能力,将是像发电厂一样的公共基础设施,专用的AI能力则是电池的形态。我非常认同这个观点,这是人工智能走向普惠,避免霸权的可靠的路径。

03

如何建设大模型时代的人工智能算力基础设施

充足的电力供应是前提,集中式,大规模,是降低成本提高使用效率的必由之路。

1万张A100卡了,部署成本如何。我们粗略计算下每小时的电能消耗。

假设选用的服务器配置如下:

Ø 每台两颗CPU,单颗CPU功耗150瓦

Ø 搭载8张SXM封装的A100卡,单颗GPU 功耗400瓦,

整机3.5千瓦;总共需要1250台服务器,总功耗,4.375兆瓦。

部署在传统风冷数据中心,PUE 按1.5计算,则需要4.375*1.5 = 6.562兆瓦。

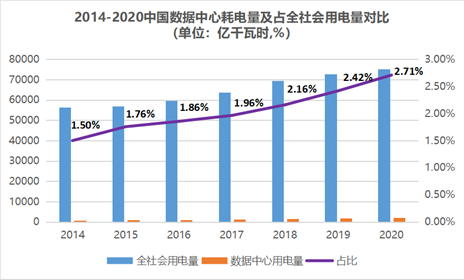

6兆瓦可以满足约6000个家庭的用电需求。一次千亿参数级别的大模型训练,需要运行大约一个月的时间。近年来,数据中心耗电量占全社会用电量同比提升了180%,预计到2030年将上升到8%。未来,在热点城市,用电的矛盾将愈加凸显。

东数西算,是国家推行的深具历史感和使命感的政策。西部拥有充足的电力,和广阔的土地资源,适合建立大规模智能算力资源池数据中心,用于各种大模型的训练。

在推理应用阶段,需要贴近用户部署,推理算力资源池数据中心应当部署在东部区域,靠近用户的地方。于是“算地矛盾”发生了。抛开数据中心基础设施带来的数字经济GDP收益,地方政府通常不欢迎数据中心产业,根源是耗能大、占地广、经济收益不显。

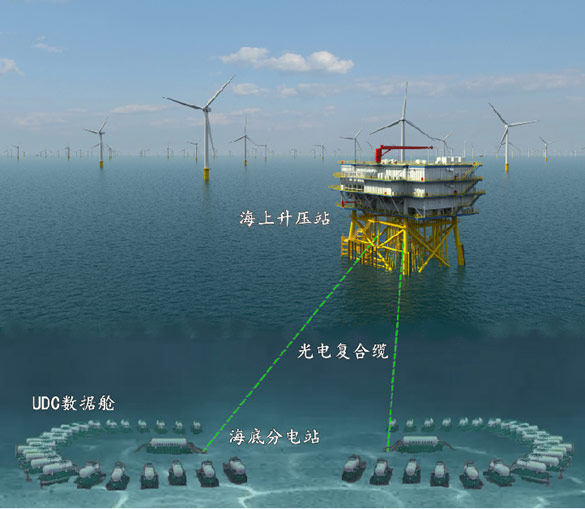

近年国家大力发展海上风电,截止2022年,装机容量达3250万千瓦!

在广袤的风电场内部署海底数据中心,就近消耗风场电力,高效“瓦特换比特”在几乎不占用城市城市土地资源的情况下,提供可靠的算力资源!这是一个充满想象力的工程!

过去几年,数字货币,区块链,元宇宙,人工智能等一波波技术浪潮,底层的依赖本质都是算力;大浪淘沙,也始终没能出现能普惠大众的应用,终究是空中楼阁,唯一的欣慰是,算力终于被卷出了新的高度。chatgpt的出现,是算力的大力出奇迹,也是算力积淀后必然的结果。

相信在不远的未来,人们的眼光会投向算力霸权或者智能霸权,创造真正的算力普惠的智能社会。